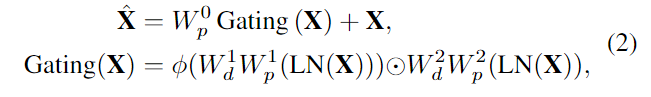

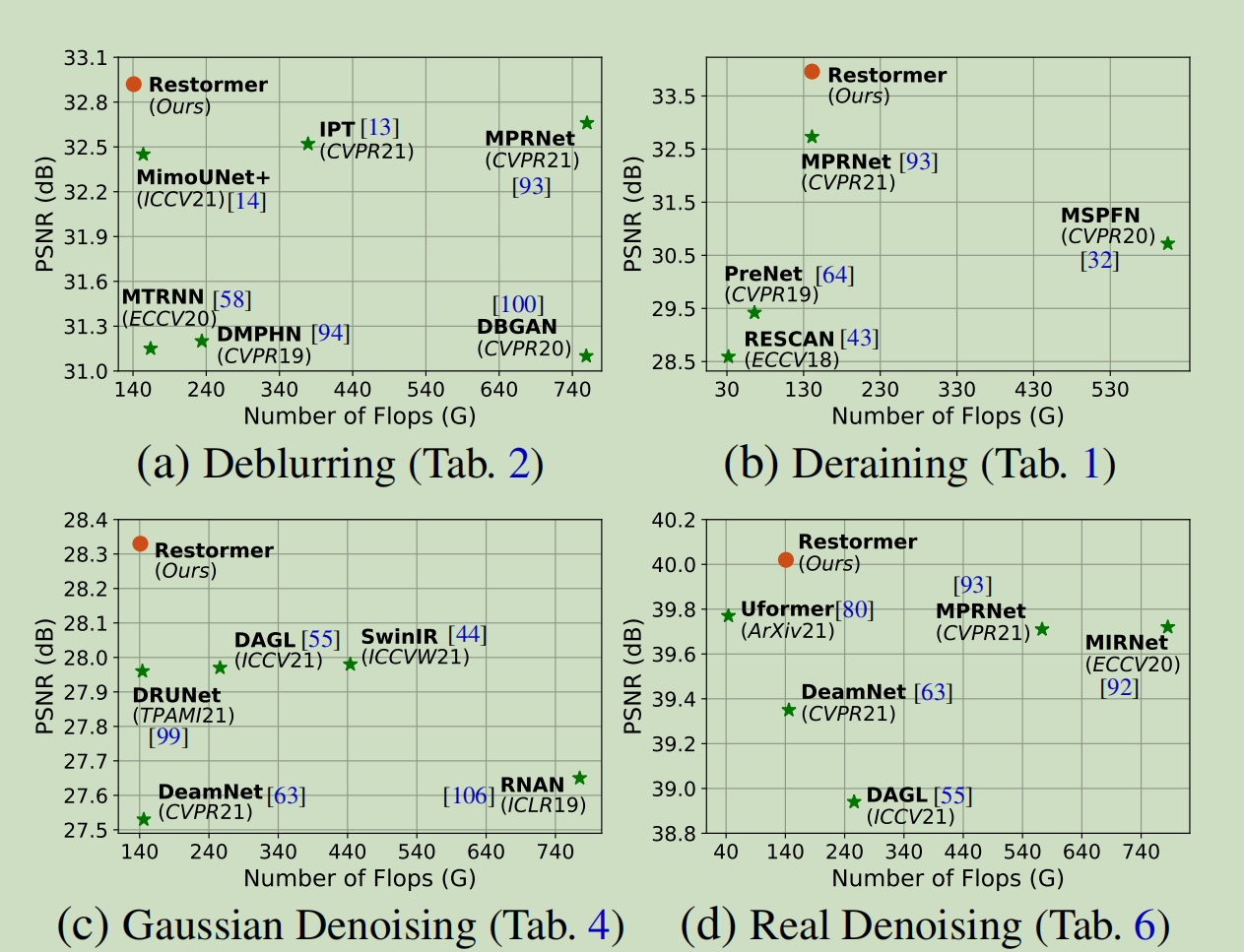

## Abstract 最近,另一类神经网络结构Transformer,在自然语言处理和高级视觉任务上表现出了显著的性能提高。虽然Transformer模型缓解了cnn的缺点(即有限的感受野和对输入内容的不适应),但其计算复杂度随着空间分辨率的增加呈二次增长,因此无法应用于大多数涉及高分辨率图像的图像恢复任务。 作者提出了一个有效Transformer模型,通过在构建块中进行几个关键的设计(多头注意和前馈网络),解决了transformer应用到高分辨率图像任务的问题,同时仍然保持了self-attention在CV任务中长距离像素关联能力。 作者将模型名为Restormer,模型在多个图像恢复任务中,包括图像去噪,取得了SOTA水平,包括单图像运动去模糊,去焦去模糊(单图像和双像素数据),图像去噪(高斯灰度/颜色去噪,和真实图像去噪)。 ## 1 Introduction ### 1.1 图像恢复任务 图像恢复是通过消除退化输入中的退化(如噪声、模糊、雨滴)来重建高质量图像的任务.这是一个高度具有挑战性的问题,通常需要很强的图像先验来进行有效的恢复。由于卷积神经网络(CNNs)在从大规模数据中学习可推广的先验方面表现良好,与传统的恢复方法相比,它们已成为一种更好的选择。 ### 1.2 CNN的局限性 CNN网络中最基础的是卷积操作,卷积操作具有局部性和平移等变性。由于这2个归纳偏置给CNN带来了不错的效果和效率,但是同时这也带来了以下2大问题。 - 卷积操作存在有限的感受野,限制了对于长距离像素依赖进行建模。 - 卷积核的参数在推理的时候参数是固定的,不能灵活的适应输入。 为了解决上面说的2个问题,引入了self-attention机制,通过计算其它位置的权重和获得,解决了上述问题。 ### 1.3 Transformer结构 self-attention机制是transformer结构的核心,mult-head self-attention有着较好的并行效率,在特征的表示上面也有较好的效果。在NLP任务和高维的CV任务例如分类、检测等方面取得了很好的效果。 虽然self-attention在捕获长程像素交互方面非常有效,但其复杂度随着空间分辨率的增加呈二次增长,因此无法应用于高分辨率图像(这是图像恢复中常见的情况)。比如在VIT中将输入图像分割成大小为48×48的不重叠的patch,分别计算每个patch上的SA。然而,限制SA的空间范围与捕捉真正的长程像素关系的目标是相矛盾的,特别是在高分辨率图像的任务上面。 #### 1.4 本文贡献 **贡献点1:一个基于transformer block构建的U-Net网络** 作者针对上述问题,提出了一种用于图像恢复的Transformer——Restormer,它能够建模全局连通性,并且仍然适用于大型图像。 **贡献点2:channel维度上的self-attention机制** 作者提出一个a multi-Dconv head ‘transposed’ attention (MDTA)结构,如下图右下角所示。通过1*1和3*3的Depthwise卷积,获得transformer中的Q、K、V矩阵。但是作者不是在空间上面计算像素之间的attention,而是转为计算每个channel之间的attention,这样就极大的降低了计算的复杂度。使得transformer机制在CV的使用中不受制于图像的分辨率影响。MDTA结构通过1*1卷积进行一个维度提升,然后利用Depthwise卷积,对每个channel上面的feature map分别进行卷积操作,实现了空间上的信息融合。最后通过self-attention机制,在channel维度上面,实现了信息的交互和融合。 **贡献点3:基于门控机制的前馈神经网络** 是传统Transformer结构的另一组成部分是(FN)前馈网络,它由两个中间具有非线性的全连接层组成。本文作者在此基础上改进,提出了Gated-Dconv forward network(GDFN),该部分采用门控机制[16]设计了FN的第一个线性转换层,以改善通过网络的信息流。该门控层被设计为两个线性投影层的元素级乘积,其中一个投影层被GELU非线性[27]激活。GDFN中的门控机制控制了哪些互补的特性应该向前流动,并允许网络层次结构中的后续层专门关注更多的重新定义的图像属性,从而拥有高质量的输出。 ## 2 Background ### 2.1 图像还原 近年来,数据驱动的CNN架构已被证明优于传统的恢复方法。在卷积设计中,基于编码-解码器的UNet架构由于其层次多尺度表示,同时保持计算效率,主要被用于恢复研究。类似地,基于跳跃连接的方法已经被证明是有效的恢复,因为它特别关注学习残差信号。空间和通道注意模块也被纳入,以选择性地关注相关信息。我们建议读者参阅NTIRE挑战报告[2,5,30,57]和最近的文献综述[8,42,73],它们总结了图像恢复网络的主要设计选择。 ### 2.2 Vison Transformer Transformer模型首先是为自然语言任务[77]中的序列处理而开发的。它已被应用于图像识别、分割、目标检测等许多视觉任务中。Vison Transformer将一个图像分解成一系列的patch(局部窗口),并学习它们之间的相互关系。这些模型的显著特点是能够学习图像patch序列之间的长期依赖关系和对给定输入内容的适应性。由于这些特点,Transformer模型也被研究用于low-level的视觉问题,如超分辨率[44,85]、图像着色[37]、去噪[13,80]和脱噪[80]。然而,变压器中SA的计算复杂度会随着图像补丁数的增加而呈二次型增加,从而阻碍了其在高分辨率图像中的应用。 一个方法是使用Swin-Transformer设计的[44]在局部图像区域[44,80]内应用自注意。然而,这种设计选择限制了局部邻域内的上下文聚合,违背了在卷积上使用自注意的主要动机,因此并不适合用于图像恢复任务。因此作者提出一个Transformer模型,它既可以学习长期依赖关系,同时保持计算效率。 ## 3 Method ### 3.1 Overall Pipeline  本文所提方法的整体架构如上图所示。其整体执行流程为:给定的图像$$R \in I^{H \times W \times 3}$$ ,Restormer 首先使用一个卷积去获得feature map$$F_0 \in I^{H \times W \times C}$$。接下来,这些浅层特征$$F_0$$通过一个 4 层对称的Encoder-Decoder结构并且转化为深层特征 $$F_d \in I^{H \times W \times 2C}。每一级编码器-解码器都包含多个 Transformer 块,块的数量从小到上逐渐增加。从高分辨率输入开始,编码器分层减少空间大小,同时扩展通道容量。解码器把低分辨率的潜在特征作为输入恢复出高分辨率表示。 对于特征下采样和上采样,作者分别应用pixel-unshuffle和pixel-shuffle操作。为了帮助恢复过程,编码器的特征通过跳过连接与解码器的特征串联在一起。串联操作之后是1*1的卷积,以减少所有层级的通道数量(减半),顶部的层级除外。在第1级,作者让 Transformer 块将编码器的低级图像特征与解码器的高级特征聚合在一起。这有助于在恢复的图像中保留精细的结构和纹理细节。接下来,在高空间分辨率下操作阶段,深层特征被进一步丰富。我们可以在实验部分中看到,这些设计选择提高了图像质量。最后,对细化后的特征采用卷积层生成残差图像$$R \in I^{H \times W \times 3}$$ ,其中添加降质的图像以获得复原的图像。 ### 3.2 Multi-Dconv Head Transposed Attention Transformers 中的主要计算开销来自于自注意力(SA)层。 在传统的 SA 中,key-query点积交互的时间和内存复杂度与输入的空间分辨率成二次方增长,即对于$$H \times W$$像素的图像,其复杂度为$$O(H^2W^2)$$。因此,将 SA 应用于涉及高分辨率图像的大多数图像复原任务是不可行的。作者提出了具有线性复杂度的 MDTA,如上图所示。关键改进是跨通道而不是空间维度应用 SA,即计算跨通道的交叉协方差来生成隐式地编码全局上下文的注意力图。 首先对于block的输入,通过Norm层之后采用$$1 \times 1$$的卷积和$$3 \times 3$$的DW卷积,得到Q,K,V三个矩阵,对其维度进行reshape操作后得到: $$Q,K,V \in R^{HW \times C}$$ 然后计算attention矩阵 $$Attention(Q, K, V) = V softmax(Q^TK / \alpha) \in R^{HW \times C}$$ 最后将结果再通过一层$$1 \times 1$$的卷积, 加上最初的shortcut连接得到结果。 ### 3.3 Gated-Dconv Feed-Forward Network 作者提出了 FN 中的两个基本修改来改进表示学习:(1)门控机制,以及(2)深度卷积。所提出的 GDFN 的架构如上图 2(b)所示。 门控机制被形式化为线性变换层的两条平行路径的元素乘积,其中之一被 GELU 非线性激活。 与在 MDTA 中一样,作者还在 GDFN 中包含深度卷积来编码来自空间相邻像素位置的信息,这对于学习局部图像结构以进行有效的图像复原很有用。  ### 3.4 渐进式学习(Progressive Learning) 在裁剪后的小 patch 上训练 Transformer 模型可能不会对全局的图像统计信息进行编码,从而在测试时的全分辨率图像上提供次优的性能。为此,作者使用渐进式学习,其中**网络在早期阶段在较小的图像 patch 上进行训练,在后期的训练阶段中逐渐增大**。通过渐进式学习在混合大小的 patch 上训练的模型在测试时表现出增强的性能,其中图像可以具备不同的分辨率(这是图像复原中的常见情况)。渐进式学习策略的行为方式类似于课程学习过程:网络从简单的任务开始,逐渐转向学习更复杂的任务(需要保留精细的图像结构/纹理)。由于对大 patch 的训练需要花费更长的时间,因此作者会随着 patch 大小的增加而减小批量大小,以保持每个优化步骤的时间与固定 patch 训练相似。 ## 4 Experiment 作者在基准数据集和实验设置上评估了所提出的Restormer:(a)图像去噪、(b)单图像运动去模糊、(c)去焦去模糊(在单图像和双像素数据上)和(d)图像去噪(在合成和真实数据上),均取得了较好的效果。  个人最近主要关注图像去噪领域,所以着重看下这部分的结果。  可以看到在SIDD和DND这两个真实图像去噪的数据集上面,作者的方法是两个数据集上唯一超过40个dBPSNR的方法。值得注意的是,在SIDD数据集上,我们的修复器比之前的最佳CNN方法MIRNet[92]和变压器模型的CNN[80]分别获得了0.3dB和0.3dB和0.25dB的PSNR增益。图6(底部一行)显示,我们的修复器在不影响精细纹理的情况下生成清晰的图像。 ## 5 Conclusion 本文提出了一种图像复原 Transformer 模型,Restormer,它在处理高分辨率图像方面具有计算效率。 作者将关键设计引入到 Transformer 块的核心组件中,以改进特征聚合和转换。 具体来说,提出的多 Dconv 头部转置注意力 (MDTA) 模块通过跨通道而不是空间维度应用自注意力来隐式地建模全局上下文,因此具有线性复杂性而不是二次方。 此外,所提出的门控 Dconv 前馈网络 (GDFN) 引入了门控机制来执行受控的特征转换。 为了将 CNN 的强度整合到 Transformer 模型中,MDTA 和 GDFN 模块都包含用于编码空间局部上下文的深度卷积。 在 16 个基准数据集上的大量实验表明,Restormer 在众多图像复原任务中实现了SOTA性能。 最后编辑:2024年04月23日 ©著作权归作者所有 赞 0 分享

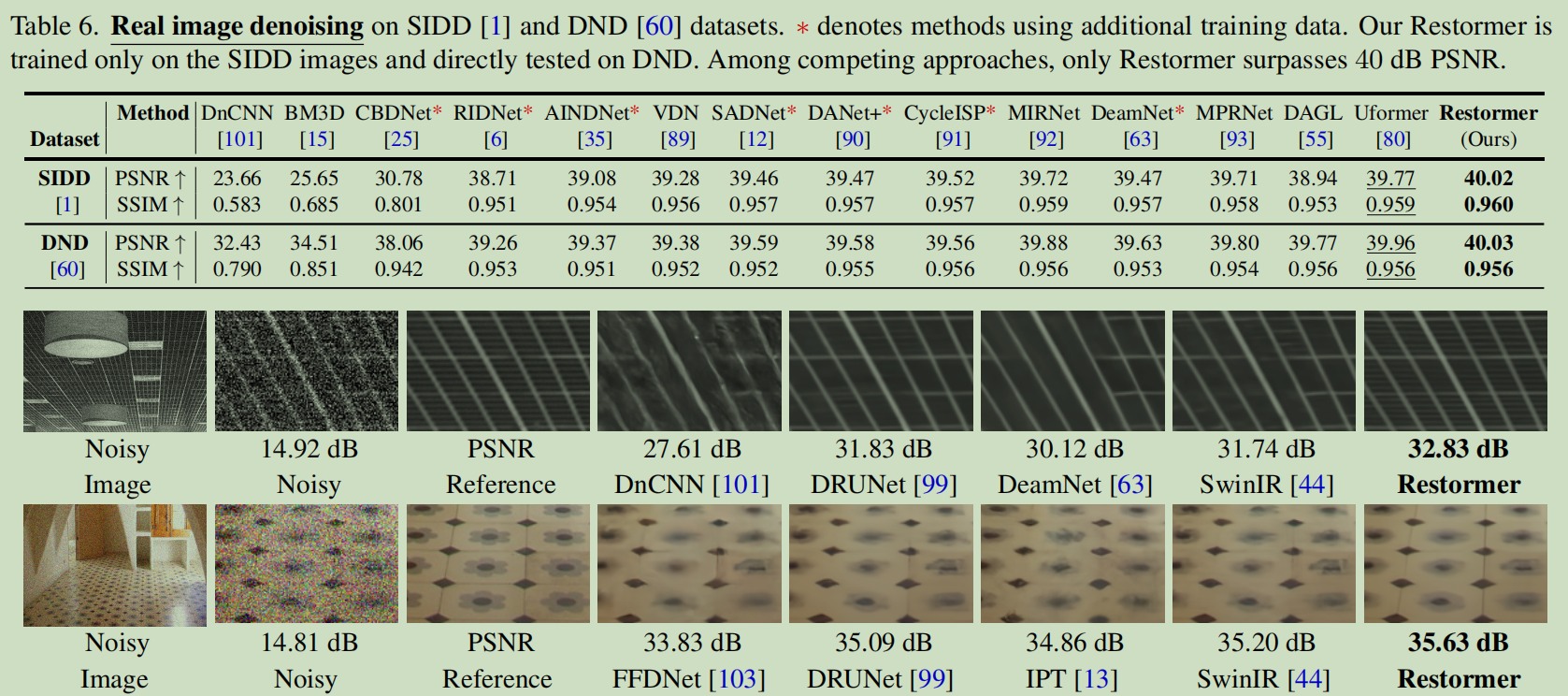

最新回复